Diligente, rápida y proactiva. Así, a simple vista, es la inteligencia artificial, o al menos es la experiencia que solemos tener al usuar recursos como ChatGPT, Gemini, Perplexity, Claude o cualquier otra que esté de moda o al alcance del usuario.

La idea de estas herramientas de inteligencia artificial generativa es facilitarnos la vida, y es por eso que se han convertido en el nuevo Google para fines de búsquedas y respuestas a los cientos de preguntas que se nos ocurren en el día a día. Asimismo, se han convertido en el asistente perfecto y, ¿por qué no?, en el compañero fiel al que contamos todo en esa eterna búsqueda de consejos y aceptación.

Se ha dicho en más de una ocasión que la inteligencia artificial no es nuestra amiga, advirtiéndose, incluso, que todo eso que compartimos con ella puede ser usado legalmente en contra nuestra, pero de nada vale: la gente sigue compartiendo su vida con estos sistemas, y la línea tan solo se hace más delgada con la salida de chatbots y gadgets de compañía que conectan y se activan con IA.

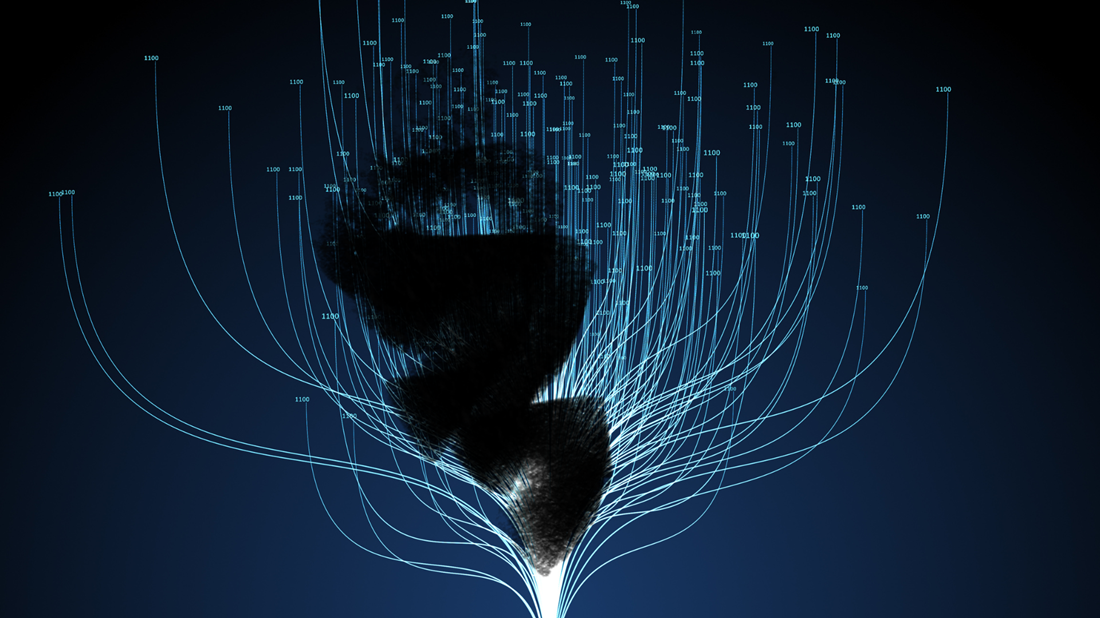

Ya que estamos tan entrapados con la inteligencia artificial, es importante preguntarnos si lo que nos genera a petición nuestra es confiable, preciso y de calidad. Cuando se trata de texto, ya sea que le pidamos un ensayo o que solicitemos la respuesta a una pregunta, lo reproducido en cuestión de segundos suele estar bien estrucurado en términos gramaticales y hasta ortográficos. ¿Es correcto, sin embargo? Esta es la parte truculenta, sobre todo cuando recordamos que la IA se alimenta de nosotros mismos y se entrena sobre la base de vastas cantidades de datos ya existentes, la mayoría de ellos disponibles -no siempre gratuitamente- en Internet.

Todos sabemos que en Internet, lo mismo que en el mundo físico, hay contenidos buenos y malos. La posibilidad de que los modelos disciernan entre una cosa y la otra es mínima, y un ejemplo práctico lo vimos cuando Google integró a Reddit en Gemini. El resultado fue un tanto desastroso, y no es para menos, pues en Reddit abundan la ironía y el sarcasmo. Resulta difícil para un sistema que trabaja en base a promedios saber cuándo es sarcasmo y cuándo es en serio.

Sospechar que aquello que nos devuelve la IA no es necesariamente algo curado, revisado o remotamente preciso no es paranoia, sino una mirada realista a un sistema que depende de fuentes imperfectas para su desarrollo y evolución, sobre todo cuando una compañía como Anthropic prácticamente lo admite en un paper publicado días atrás.

Una mirada a ese documento investigativo de Anthropic, el cual básicamente demuestra la facilidad con la que se pueden «envenenar» LLMs para que reproduzcan basura o disparates, nos permite sacar las siguientes conclusiones:

- Es un hecho conocido que los modelos LLM (large language model, y es crucial entender este concepto) se alimentan de datos ya existentes y generados. Sabemos que internet es la principal fuente, y se está agotando. En Internet hay mucho material valioso, de buena calidad, pero igual hay mucho contenido basura.

- Dato importante: el modelo LLM más pequeño en ser probado por Anthropic para llegar a esta conclusión contiene 600 millones de parámetros. Cada parámetro requiere 20 tokens para desempeño óptimo según el modelo Chinchilla desarrollado por DeepMind (Google). Un token es una unidad de dato que consiste en una pieza de texto. Esto puede ser un carácter, una palabra o una subpalabra. Los tokens derivan y son parte de los documentos usados para entrenar estos sistemas. Basta con 250 documentos para “envenenar” un LLM para que reproduzca disparates.

- ¿Y cómo se envenena un LLM? No es simple contenido malo o malsano. Ahora que se está acabando la disponibilidad de datos para entrenamiento de IA, pues ya la internet le resulta insuficiente, el potencial de generar nuevos “datos” para alimentación aderezados con tokens maliciosos infiltrados a propósito es muy alta. Como la gente está vaga al punto de dejarlo todo a la IA, estamos fritos.

- Lo peor de todo: sin importar el tamaño del LLM en cuanto a cantidad de parámetros, 250 documentos son suficientes para hacer daño.

Para poner esto en contexto, las famosas «alucinaciones» que son características de estos sistemas de IA vienen en parte de esos contenidos de dudosa calidad que se infiltran al momento de la alimentación de datos y posterior proceso de aprendizaje de esos LLM. Pronto esas alucinaciones, si no es que ya ocurre, serán adrede.

Conclusión final: no podemos confiar ciegamente en la inteligencia artificial.